Ryzen AI Max+ 395とメモリ128GBのミニPC「A9 MEGA」がGEEKOMから登場 - PC Watch

ミニPCは見ていて楽しい。ミニPCには夢がある。

化物PC

RTX4060よりはやーいとかいう噂もあったRyzen AI Max+ 395 + 128GB RAMという化物ミニPCだが、1900ドル、つまり30万円くらいとして出資を募っているらしい。

GEEKOMは、CPUにRyzen AI Max+ 395、メモリに128GBを搭載したミニPC「A9 MEGA」を、クラウドファンディングサイトKickstarter上で出資を募り始めた。入手するのに必要な出資額は1,899ドル(約28万円)

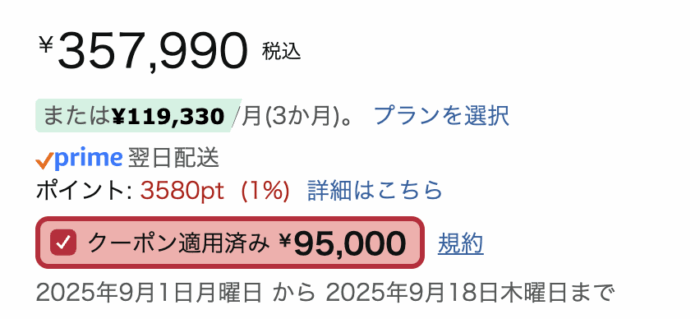

ちなみにAmazonだとGMKtecが96GB RAMのやつを26万くらいで売ってる。

価格設定は36万だが例によってクーポン商法なので。

95,000円クーポンってなんぞwこれ適用し忘れる人類も世の中にはいるのだろうか。

こっから+3万くらいで128GB RAMにできたら嬉しいよね。中華ミニPCの競争は凄まじい。ただ中華ミニPCに30万出せるのか問題はある。

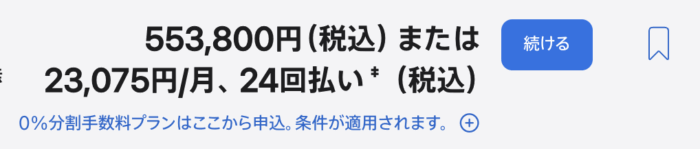

ブランドでいくとAppleなのだが、M4 Mac Studioで128GB RAMにしようと思ったら、最小でも553,800円だって🥺

ちなみにこれは16コアCPU、40コアGPU、NE16コアの構成。GEEKOMの倍の値段と考えるとつらい感じはする。

ローカルLLMやStable Diffusionで

うちには既にRTX 4070があるので、推論だとStable DiffusionならSDXLモデルも扱えるしまぁまぁ不満はないんだけれど、LLMでデカいモデルを動かしたい、みたいなのだと、現状はやっぱり統合モデルが唯一解になるんだろうか。

M2 Pro Mac miniもLLMの推論ならそれなりに動いてくれるので、DeepSeekの13Bくらいのやつを使ったりしているんだけれど、正直阿呆なのは否めない。かなり限定的なタスクじゃないと厳しい現状はある。これが70Bや120Bだったら強いんだろうか?という期待もあるが、どうなんだろうなぁ。

まぁ手元にはRTX 4070があるので、マザボとVRAM揃えて……というのも考えられるんだけれど、やっぱり帯域幅がネックになる気がする。ちなみにこの分離のアーキテクチャでは下記記事がとても参考になって

OpenAIの「オープンなAI(gpt-oss-120b)」はGPUサーバじゃないと動かない?→約30万円の自作PCで動かしてみた - ITmedia AI+

gpt-oss-120bが8.4token/s出たらしい。コンテクスト長は8192だが、ローカルLLMだと現状簡潔なタスクやちょっとした会話くらいだろうな、というのはあるのでまぁよいのではないか。

PCIe 4.0 x16だと転送速度は理論値32GB/sでそれがネックなら、メモリ帯域幅が256GB/sのRyzen AI Max+ 395ならけっこう期待できるのかなぁ。

そんなわけで、買わないミニPCを見てほしいなぁと言い続けるだけの毎日である。

(追記)買った😄

コメント