30万円で買ったGMKtec EVO-X2をフル活用するべく、色々といじっている。チャット機能はやはりほしいのでいじる。

環境と構成

- ホストマシン

- Intel Mac mini 2018

- Docker Desktop for Mac 4.51.0

- Open WebUI

- Intel Mac mini 2018

- サーバ

- GMKtec EVO-X2

- Ryzen AI Max+ 395

- 128GB

- Windows 11

- LM Studio 0.3.30

- gpt-oss-120b

- GMKtec EVO-X2

ホストマシンはM2 Pro Mac mini + OrbStackでもやった。

LM Studioはインストールして、モデルを入れているものとする。

ざっくり構成

ざっくり手順

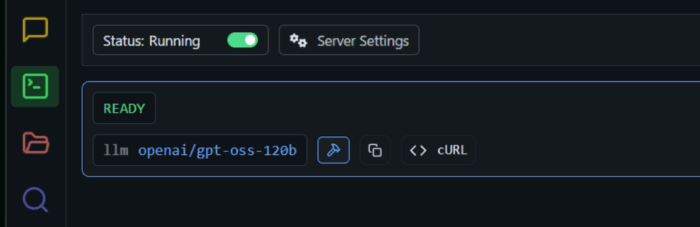

LM Studio入れてAPI使えるようにする

公式サイトからインストールするだけ。APIサーバは左側のタブの2番目。

IPアドレスとかも表示される。ポート番号は1234。以下で確認する。

curl http://IP:1234/v1/modelsEVO-X2 VRAMを64GB -> 96GBにする

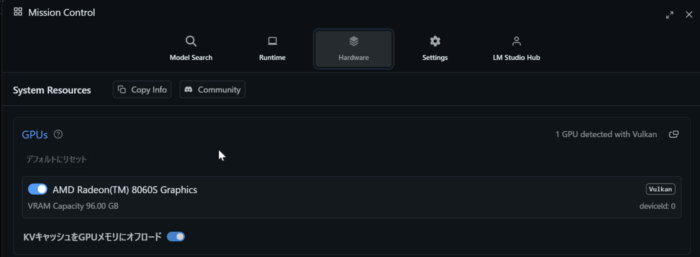

一応。

割り当てについてはLM Studioで確認できる。

AMDのソフトウェアからも変更できそうに見えるが、なんぼやっても変更されなかった。結局BIOSだよ。ESC押しまくってBIOSに入ったら、それっぽい項目を探す。それっぽいところに潜っていくと「UMA Frame Buffer Size」という名前のやつがあるから、それ。

Open WebUI のインストール

以下の docker-compose.ymlを作る。ポートは好きなの開ける。

version: '3.8'

services:

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

restart: always

ports:

- "8080:8080"

volumes:

- open-webui:/app/backend/data

# 永続化のためのボリューム定義

volumes:

open-webui:

# Dockerにボリュームを管理させるデフォルト設定

http://IPアドレス:ポートにアクセスすると、最初に管理者ユーザを作成することになる。

Open WebUI から LM Studioを繋げる

ユーザアイコンから管理者パネルを開いて、「接続」タブ。

- 接続タイプ: ローカル

- URL:

http://LM StudioあるマシンのIPアドレス:1234/v1 - 認証: なし

- Provider TYpe: OpenAI

そしたらチャットで選択できるようになる。

なんか適当に話す。

gpt-oss-120bとの会話の雑感

とりあえず日本語で話す限りは阿呆だなぁと思う。絶妙に話が通じなくて、あまり話す気がしない。GPT-3.5の時はどうだったかなぁ。英語だともうちょっとマシなんだろうか。

Geminiの無料枠は非常に大きいという現状、正直宗教的な理由以外でわざわざgpt-oss-120bを使ってチャットする理由はちょっと思い当たらない。

ツールとかと連携させるなら、使い所あるのかな?うーん。

企業の都合で勝手に変えられない、というのは大きいかも。いくらチューニングしてもアプデで滅茶苦茶になるこんな世の中じゃ。

また、インターネットから隔絶された環境でもけっこうな知にアクセスができる、というのは非常に大きいのではないか、と思われる。いつまでもあると思うなインターネット。真面目な話、ネットに繋がせてもらえない環境は実在するので、そういうところにあると神になると思われる……が、そんなところで30万円するEVO-X2を導入できんか。つらいなぁ。

コメント